隨著人工智能技術在各行各業的深度融合與廣泛應用,其帶來的效率革命與創新機遇有目共睹。算法偏見、數據隱私泄露、系統被惡意利用等安全風險也隨之凸顯,對個人權益、社會公平乃至國家安全構成了新的挑戰。因此,構建一個安全、可信、負責任的人工智能生態系統,已成為全球共識。這一目標的實現,離不開兩大支柱的協同并進:頂層設計的“人工智能安全政策與標準”與落地實踐的“人工智能應用軟件開發”。二者如同車之雙輪、鳥之兩翼,共同驅動著人工智能產業向著健康、可持續的方向發展。

一、 人工智能安全政策與標準:劃定發展的安全邊界與倫理紅線

人工智能安全政策與標準是確保技術發展不偏離正確軌道的“導航系統”和“交通規則”。它們從宏觀層面為人工智能的研發、部署與應用劃定安全邊界與倫理紅線。

- 政策引領方向:世界主要國家和地區紛紛出臺人工智能發展戰略與治理框架。例如,歐盟的《人工智能法案》旨在基于風險等級對AI系統進行規制,嚴格禁止某些高風險應用;中國的《新一代人工智能治理原則》強調發展負責任的人工智能,倡導“和諧友好、公平公正、包容共享、尊重隱私、安全可控、共擔責任、開放協作、敏捷治理”等原則。這些政策文件明確了發展價值觀,強調了安全可控、隱私保護、公平非歧視等核心要求,為產業界提供了清晰的合規指引。

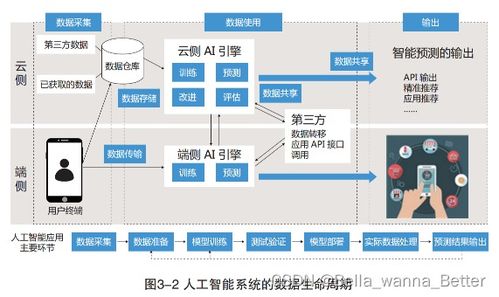

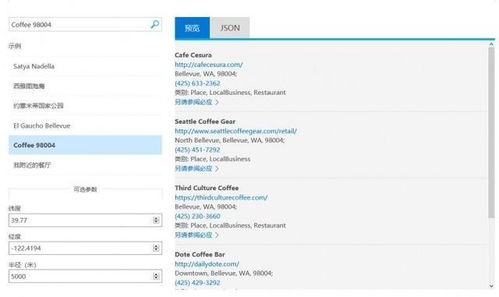

- 標準提供抓手:政策的原則性要求需要通過具體的技術與管理標準來落地。國際標準化組織(ISO)、國際電工委員會(IEC)以及各國的標準機構正在加緊制定人工智能安全、可信賴性、數據治理等方面的標準。這些標準涵蓋了從數據采集、模型訓練、算法評估到系統部署、運行監控的全生命周期,為開發者和企業提供了可操作、可評估的技術規范。例如,關于算法公平性的評估標準、隱私保護計算的技術標準、AI系統安全測試的指南等,都是將安全倫理要求“編碼”入開發流程的關鍵工具。

二、 人工智能應用軟件開發:將安全與可信內化于技術實踐

再好的政策與標準,最終需要在具體的軟件開發過程中得到貫徹。人工智能應用軟件的開發者是構建安全防線的第一責任人,必須在軟件開發生命周期(SDLC)的每個環節嵌入安全與可信的考量。

- “安全左移”與“設計即安全”:傳統的安全措施往往在開發后期才介入,對于AI系統而言為時已晚。現代安全實踐強調“安全左移”,即在需求分析、架構設計階段就充分考慮安全與隱私需求。這意味著在設計算法模型時,就要評估其可能帶來的偏見、可解釋性不足等風險;在設計數據管道時,就要融入數據脫敏、加密和最小權限原則。

- 全生命周期安全管理:

- 數據階段:確保訓練數據的代表性、質量以及來源的合法性,實施嚴格的數據訪問控制和隱私保護技術(如差分隱私、聯邦學習)。

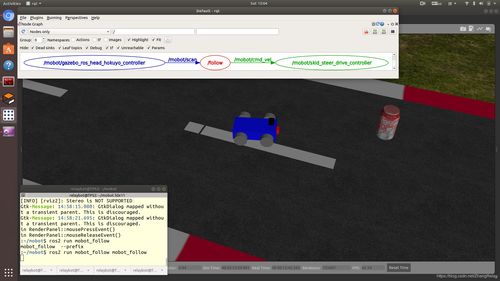

- 模型開發階段:進行持續的公平性測試和偏見檢測,提升模型的可解釋性,對模型進行對抗性樣本魯棒性訓練。

- 部署與運維階段:建立模型的持續監控機制,能夠檢測模型性能衰減、輸入數據漂移以及潛在的惡意攻擊;制定明確的應急預案和模型回滾機制。

- 供應鏈安全:關注所使用的開源框架、預訓練模型、第三方API的安全性,管理好軟件物料清單(SBOM)。

- 工具與文化賦能:開發者需要借助自動化的安全測試工具、公平性評估工具包、漏洞掃描工具等來提升效率。在企業內部培育“安全與可信”的文化至關重要,通過培訓讓每一位工程師都理解其重要性,并落實到日常代碼編寫和系統設計中。

三、 政策標準與軟件開發的協同閉環

政策、標準與軟件開發并非孤立的環節,而是構成了一個動態增強的協同閉環:

- 政策驅動標準與開發:宏觀政策指明風險領域和治理重點,催生具體的技術與管理標準。這些標準又直接引導和約束軟件開發實踐,例如要求軟件必須通過特定的安全認證或符合某類公平性指標。

- 開發實踐反饋與完善標準:在軟件開發與落地應用中遇到的新問題、新挑戰(如新型對抗攻擊、復雜的多模態倫理困境),會反過來為標準的修訂和政策的完善提供實踐依據,推動治理框架與時俱進。

- 技術賦能治理:人工智能技術本身也可以用于賦能安全治理,例如利用AI進行自動化合規檢查、監測網絡空間中的惡意AI應用、分析算法偏見等,形成“以AI治理AI”的良性循環。

結論

人工智能的安全與可信是一項系統性工程。堅實的“人工智能安全政策與標準”為整個行業樹立了清晰的規則和期望,而負責任、有意識的“人工智能應用軟件開發”則是將這些規則轉化為安全產品與服務的關鍵過程。只有兩者緊密結合,讓合規要求深度融入技術血脈,讓開發實踐不斷反饋優化規則,我們才能有效駕馭人工智能這把“雙刃劍”,在享受其巨大紅利的牢牢守住安全的底線,最終實現科技向善,造福人類社會。